北京大学CraftJarvis团队在「我的世界」中探索通用智能体设计的新突破

在人工智能迅猛发展的今天,一个引人注目的问题浮现:能否摆脱文本标注和环境的直接作用,仅凭游戏视频就能训练智能体?这个问题不仅对传统方法提出了挑战,同时也蕴藏着巨大的潜力,吸引了众多目光。

游戏视频教学的设想

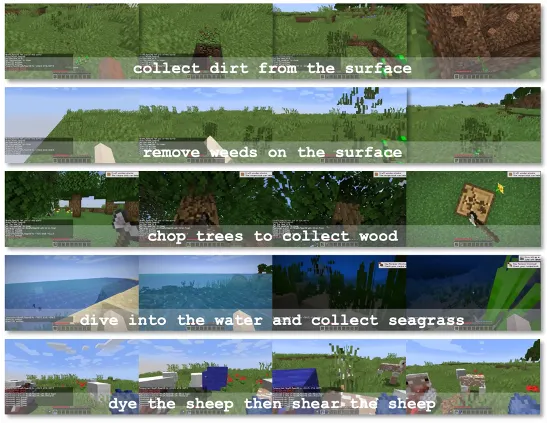

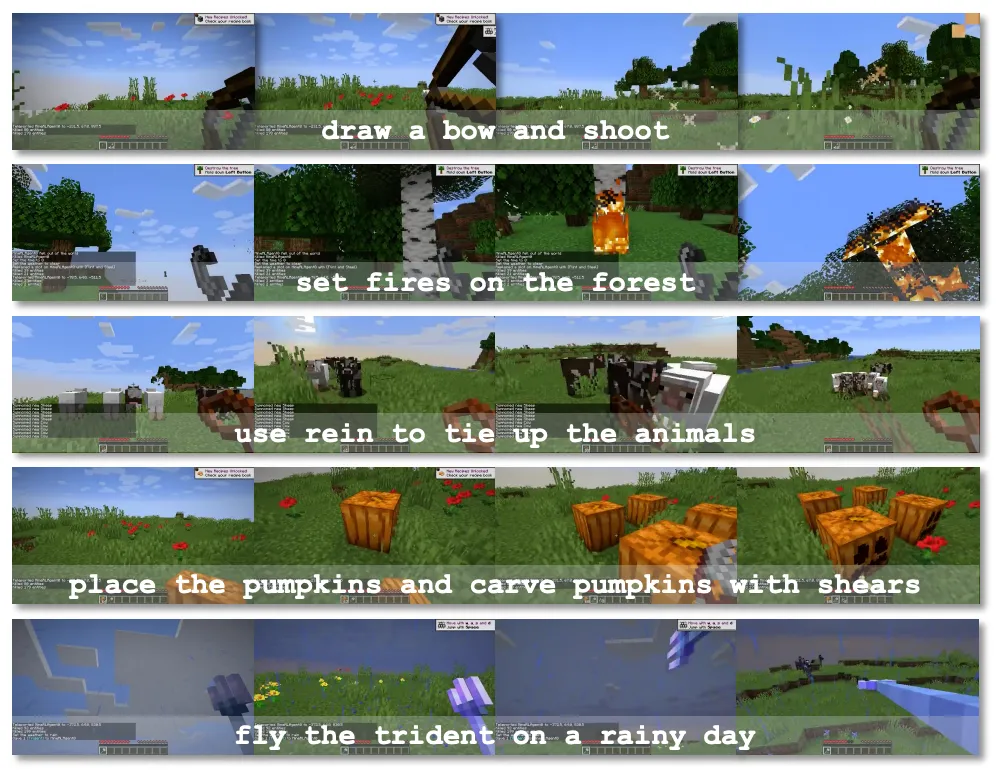

现在,智能体通常需要依赖大量标记和与环境的互动来学习,然而获取高质量的“文本-视频”资料却相当困难。因此,研究团队提出了一个新颖的点子,他们打算利用丰富的视频资料,通过观察游戏视频,使智能体学会理解世界并完成指定任务。这一创新思路为智能体的学习开辟了新的途径。比如,在一些特定任务中,获取特定场景下的优质标注数据非常困难,但视频资料却能大量获取,这就充分展示了这种方法的实用性。

视频是大家常见的记录手段,其中所含信息客观存在。如果智能系统能够从视频中学习技能,那么它的学习范围和层次将会显著扩大和加深。

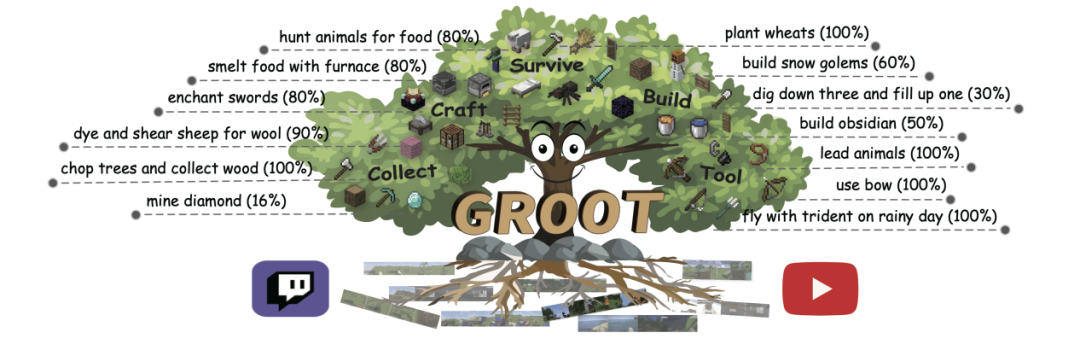

参考视频指令的创新

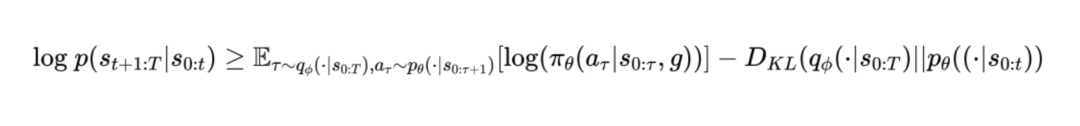

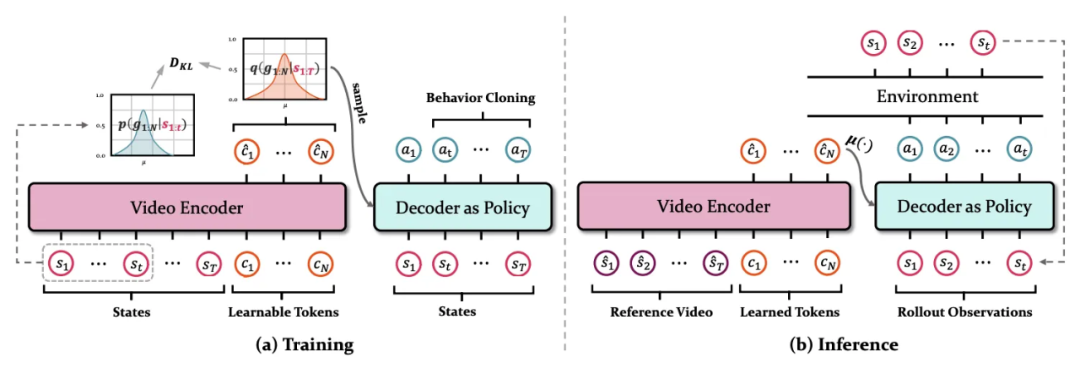

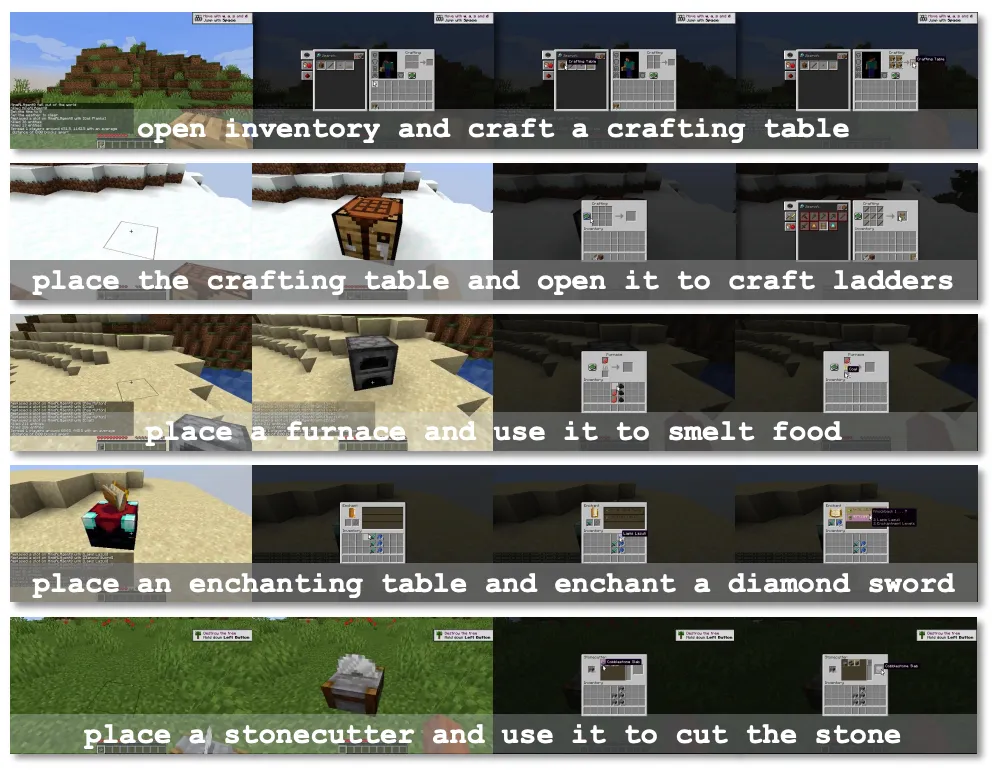

传统指令存在不少缺陷,为此团队巧妙地将“参考视频”引入指令表述。与之前繁琐的指令方式相比,这种方式显得更为简洁。过去,完成一个任务可能需要大量文字来描述,而现在只需一段视频就能传达相应的指令。此外,他们还设计了全新的架构和自监督训练技术,这有助于融合指令空间和指令执行策略。

这种方法能有效解决先前指令方式中的一些问题。先前那些指令可能导致智能体学习难度大,效果也不理想。然而,目前以视频形式作为指令仍存在不少挑战,比如需要确立新的评价准则等问题。

LLM 在智能体任务中的应用

GPT变得流行后,人们开始尝试让大型语言模型(LLM)参与智能体任务。像DEPS、Voyager、GITM等项目都在利用LLM的规划推理能力来处理“我的世界”中的任务。这些尝试让智能体在执行复杂长期任务时有了更多选择。比如,在“我的世界”游戏中建造大型建筑这样的任务,LLM能帮助智能体做好提前规划。

然而,使用LLM并非全然无弊。它可能受限于语言,且在不同情境下,模型可能需调整,这一点研究人员需认真思考并解决。

任务多样性与成本挑战

单独为每个任务设立奖励机制,智能体通过互动学习所需成本过高,且存在安全隐患。各个任务环境各不相同,难以统一设定奖励函数,这就像针对性格迥异的孩子制定不同的激励方法,相当繁琐。此外,不同任务的学习时间和资源消耗也难以进行有效控制。

这种方式运用大量视频数据对智能体进行自我监督预训练,前景看好。网络上的视频资源丰富,适合大规模训练智能体。谷歌以前曾用众多网络图像进行预训练,效果颇佳。在智能体训练领域,视频预训练或许也能达到类似的好效果。

指令表达能力与学习成本平衡

当前主流指令模式存在不少缺陷。比如,指令的表述能力受限,常常会导致理解上的困惑。尽管自然语言指令能在一定程度上解决问题,但获取高质量的视频与文本数据却相当困难。例如,一张站在房屋前的图片可能会让智能体无法确定是去建造还是寻找房屋,这凸显了指令存在歧义的问题。

研究团队的目标是寻求指令表达与学习成本之间的平衡,以便提升智能体的学习效率。若能实现这一平衡,智能体在完成任务时将表现出更高的准确性和速度。

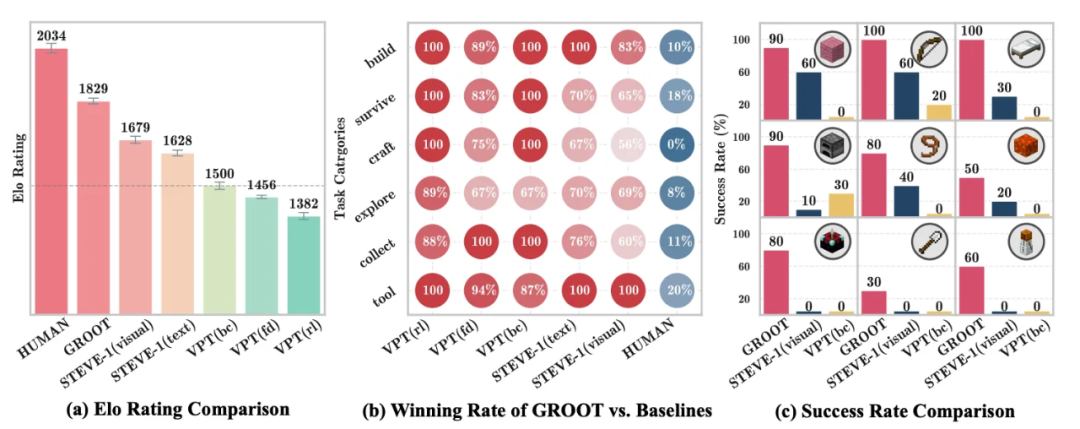

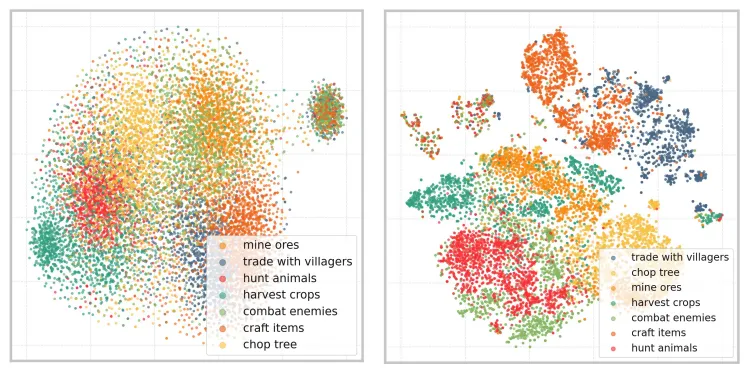

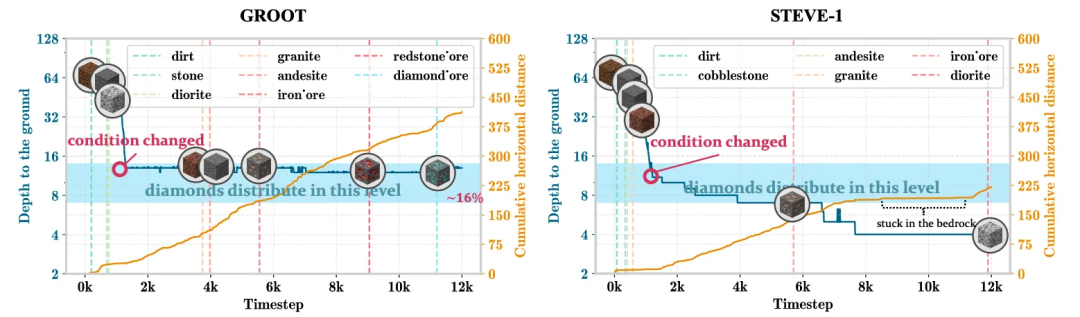

模型的推理与展示

在推理环节,只要输入相关视频,智能体便能够完成指定任务,这一标准体现了模型的应用广泛性。这对于“我的世界”中的多任务智能体研究来说,具有非常重要的意义。研究团队还展示了训练前后的指令空间编码效果,简化了任务展示,提升了智能体的表现,并利用预训练的大语言模型增强了其处理长期任务的能力。例如,通过简化智能体使用铁镐进行钻石挖掘的任务,便于观察其表现。类似DEPS这样的具有目标选择器的智能体,为后续研究提供了参考。

你觉得仅通过游戏录像来训练智能体,这样的方法将来会流行起来吗?期待你发表看法,并且能对这篇文章给予点赞和转发。

转载原创文章请注明,转载自棋牌游戏开发/手机棋牌开发/房卡棋牌APP游戏定制开发公司,原文地址:http://qipaikaifa.net/post/889.html